آشنایی با GPT-4؛ جدیدترین مدل هوش مصنوعی OpenAI

نمایش خبر

| تاریخ : 1401/12/26 نویسنده: مسعود بهرامی شرق | ||

| برچسبها : | اوپن ا آی OpenAI ، هوش مصنوعی Artificial Intelligence ، مایکروسافت Microsoft ، چت جی پی تی ChatGPT | |

به گفته OpenAI، مدل هوش مصنوعی GPT-4 جدیدترین دستاورد شرکت در راستای ارتقاء یادگیری عمیق (deep learning) محسوب میشود. این استارتآپ آمریکایی مدل هوش مصنوعی جدید خود را یک تکنولوژی «چندوجهی» یا multimodal مینامد؛ به این معنی که علاوه بر متن، محرکهای تصویری نیز میتوانند این مدل را به تولید محتوا وادارند. در حال حاضر، قابلیت ورودی متن صرفا در اختیار مشترکین ChatGPT Plus و توسعهدهندگان نرمافزار است، اما قابلیت ورودی تصویر همچنان جزئی از پیشنمایش این پژوهش محسوب میشود.

در حقیقت، GPT-4 پیش از این به شکل غیررسمی معرفی شده بود. چنانچه شما در Bing Preview ثبت نام کرده باشید، حداقل در پنج هفته اخیر در حال استفاده از GPT-4 بودهاید (میتوانید از اینجا در مرورگر Edge ثبت نام کنید). البته این خود GPT-4 نیست، بلکه ورژنی است که بر حسب نیاز جستوجوی اینترنتی، توسط مایکروسافت تغییراتی در آن اعمال شده است.

به گفته OpenAI، شاید GPT-3.5 و GPT-4 شبیه هم به نظر برسند، اما تفاوت آنها زمانی آشکار میشود که سطح دشواری کار به آستانه کافی برسد. GPT-4 قابلاعتمادتر و خلاقتر بوده و قادر است دستورالعملهای متنوع (با تفاوتهای بسیار ریز) را اجرا کند. گرگ باکمن (Greg Bockman)، که ریاست OpenAI را بر عهده دارد، وقتی قصد داشت تواناییهای این تکنولوژی جدید را به شکل آنلاین به نمایش بگذارد، تصویری از طرح یک وبسایت ساده که با دست کشیده شده بود را به GPT-4 ارائه کرد و این مدل هوشمند، یک وبسایت واقعی را بر مبنای آن ایجاد کرد. همچنین در این نمایش آنلاین، باکمن نشان داد که GPT-4 چگونه میتواند به افراد در محاسبه مالیات آنها کمک کند.

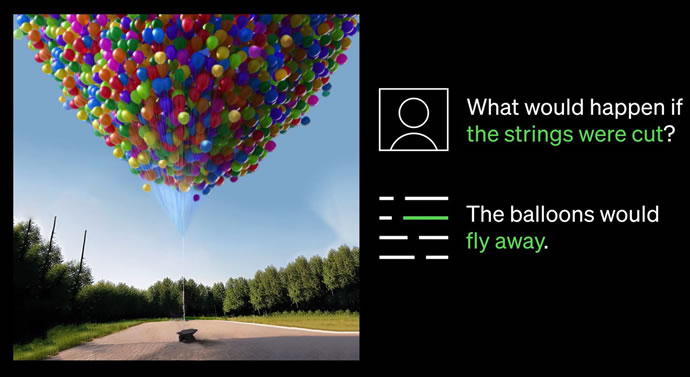

بر خلاف GPT-3.5 – که فقط ورودی متنی را قبول میکند – GPT-4 میتواند ترکیبی از متن و تصویر را به عنوان ورودی بپذیرد. برای اینکه مشخص شود GPT-4 چه تواناییهایی دارد، بد نیست به مثال زیر توجه کنید. اخیرا یک عکس متشکل از سه تصویر با درونمایه طنز در شبکه اجتماعی Reddit منتشر شده است. برای درک نکته خندهدار این عکس، مخاطب باید اطلاعاتی حداقلی درباره دنیای فناوری را داشته باشد. حال، فرض کنیم مخاطب فاقد چنین اطلاعاتی بوده و برای سردرآوردن از موضوع، سوال خود را به همراه عکس مورد نظر (متن+تصویر) به این شکل مطرح میکند:

«چه چیزی در تصویر خندهدار است؟ آن را بخش به بخش توصیف کن.»

حال نگاهی میاندازیم به پاسخ ارائه شده از سوی GPT-4:

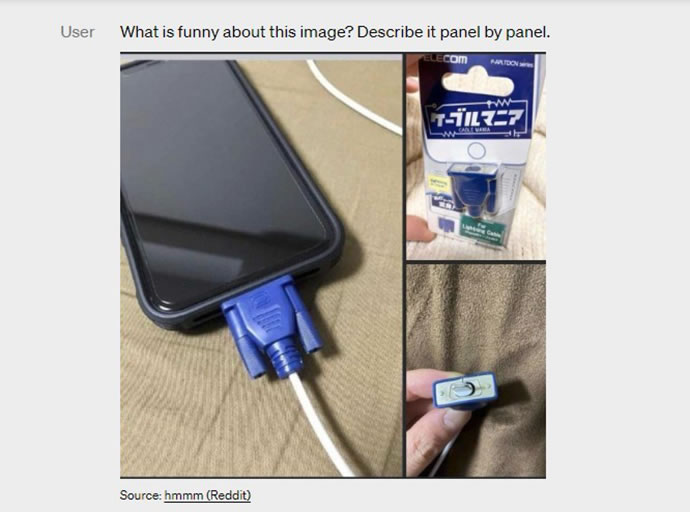

این تصویر، یک بستهبندی از آداپتور «کابل لایتنینگ» را نشان میدهد در سه بخش.

بخش اول: یک گوشی هوشمند با کانکتور VGA (یک کانکتور 15-پینی بزرگ و آبیرنگ که عموما برای مانیتور کامپیوتر استفاده میشود) که به درگاه شارژ آن متصل شده است.

بخش دوم: بستهبندی آداپتور «کابل لایتنینگ» با تصویری از کانکتور VGA روی آن.

بخش سوم: نمای نزدیکی از کانکتور VGA با یک کانکتور کوچک لایتنینگ (که برای شارژ کردن آیفون و دیگر دیوایسهای اپل استفاده میشود).

طنز ماجرای این تصویر در آنجاست که وصل کردن یک کانکتور VGA بزرگ و منسوخشده به درگاه شارژ یک گوشی هوشمند کوچک و مدرن، مضحک به نظر میرسد.

البته قابلیت درک تصاویر هنوز در اختیار همه مشتریان قرار نگرفته و در حال حاضر OpenAI در حال آزمودن این قابلیت با شرکت دانمارکی Be My Eyes (طراح اپلیکیشنی با همین نام مخصوص نابینایان و کمبینایان) است. یکی از امکانات این اپلیکیشن تحت عنوان Virtual Volunteer به پشتوانه GPT-4 میتواند به سؤالات پرسیده شده درباره تصاویر ارسالی پاسخ دهد. Be My Eyes نحوه کار این قابلیت را این گونه توضیح میدهد:

به عنوان مثال، اگر کاربری یک عکس از داخل یخچال خود ارسال کند، Virtual Volunteer نه تنها میتواند محتویات آن را به درستی شناسایی کند، بلکه قادر است تحلیل کند که با آن مواد چه غذاهایی میتوان درست کرد. این ابزار همچنین میتواند چند دستور تهیه غذا به کاربر پیشنهاد کرده و آنها را با راهنماییهای مرحله به مرحله برای کاربر ارسال کند.

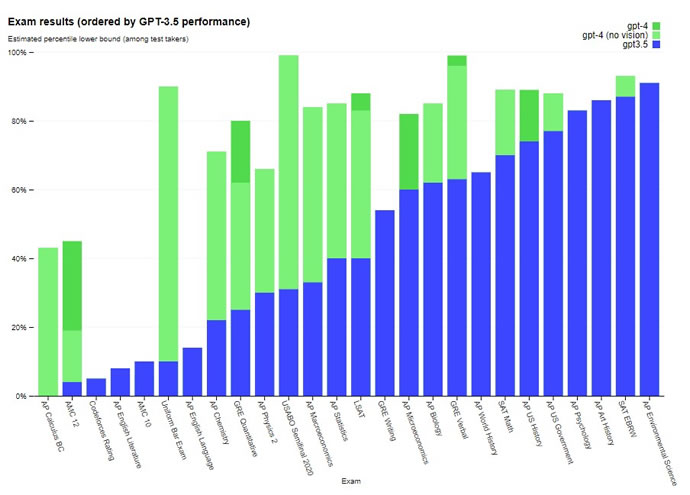

تیم توسعهدهندگان GPT-4 در OpenAI، این مدل را با کتابهای حاوی نمونهسوالات امتحانی سالهای 2022 و 2023 مورد امتحان قرار دادند. برمبنای پاسخهای داده شده، مشخص شد که GPT-4 نسبت به ورژن قبلی هوشمندتر شده است. توجه داشته باشید که تمام دانستههای این مدل به قبل از سپتامبر 2021 برمیگردد، لذا این امتحانها (و پاسخهای آنها) جزو دادههای تمرینی به حساب نمیآیند.

طبق ادعای OpenAI، مدل هوش مصنوعی GPT-4 میتواند در بسیاری از حوزههای حرفهای و آکادمیک، عملکردی در سطح یک انسان را به نمایش بگذارد. جالب است بدانید تیم توسعهدهندگان OpenAI، نسخه شبیهسازی شده آزمون وکالت bar exam را – که همه وکلا باید در آن نمره قبولی کسب کنند – به هر دو مدل ارائه کردند. نمره کسبشده توسط GPT-4 در بین نمرات 10 درصد بالای شرکتکنندگان قرار میگیرد، در حالی که نمره GPT-3.5 چندان جالب نبوده و در جمع 10 درصد پایینی شرکتکنندگان قرار میگیرد.

آزمونهای دیگری نیز از این دو مدل هوش مصنوعی به عمل آمد. از جمله آزمون پذیرش دانشکده حقوق یا در اصطلاح LSAT که GPT-4 موفق شد در صدک 88ام جای بگیرد، در حالی که نمره GPT-3.5 بهتر از صدک 40ام نبود. به طریق مشابه، پس از گذراندن آزمون ریاضی SAT، صدک89ام توسط GPT-4 و صدک 70ام توسط GPT-3.5 احراز شد.

شاید مهمترین قابلیتی که به GPT-4 اضافه شده، هدایتپذیری باشد. پیش از این، ChatGPT با الصاق برخی قواعد در ابتدای آن، به ناچار رفتاری مثل یک دستیار دیجیتال را بروز میداد. به طوری که این امکان وجود داشت تا با فریب دادن هوش مصنوعی، بتوان به این قواعد پی برد. اما مایکروسافت و OpenAI تلاش کردند تا با پنهان کردن این قواعد، از فریب خوردن این مدل – یا در اصطلاح «جیلبریک شدن» آن – جلوگیری کنند.

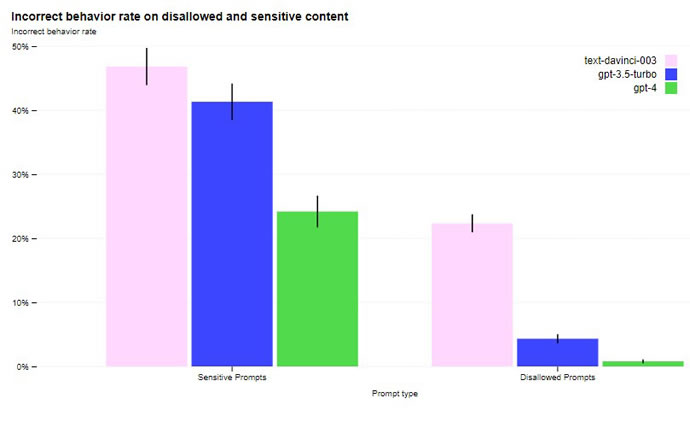

لازم به ذکر است، GPT-4 هنوز هم محدودیتهای خود را دارد، به ویژه زمانی که پای حقایق در میان باشد. مثل ورژن قبلی، GPT-4 نیز میتواند پاسخهای نامربوطی بدهد که در اصطلاح «هذیانگویی» نامیده میشوند. البته از لحاظ پایبند بودن به حقایق و نیفتادن در دام اشتباهات منطقی، GPT-4 به طور چشمگیری بهتر از GPT-3.5 عمل کرده و نمراتش در تستهای به عمل آمده، تا 40 درصد بالاتر بوده، اما هنوز کامل و بینقص نیست.

طبق اذعان OpenAI، مدل هوش مصنوعی GPT-4 پس از قطع دادههایش (در سپتامبر 2021) از مسائل و اتفاقات روز بیخبر بوده و نمیتواند از تجربه خود یاد بگیرد. GPT-4 گاهی اوقات در استدلالهای ساده دچار خطا شده و در پذیرش گزارههای غلط از سوی کاربران (که غلط بودن آنها کاملا واضح است) دچار اشتباه میشود. گاهی اوقات نیز درست مثل انسانها در حل مسائل دشوار شکست میخورد. البته از برخی جهات GPT-4 به پیشرفتهای چشمگیری دست پیدا کرده است.

به عنوان مثال اگر از GPT-4 درباره نحوه ترکیب مواد شیمیایی خطرناک راهنمایی بخواهید، به احتمال زیاد به درخواست شما پاسخ نخواهد داد. به گفته OpenAI، احتمال پاسخگویی GPT-4 به درخواست برای دسترسی به محتواهای غیرمجاز تا 82 درصد نسبت به GPT-3.5 کمتر شده است. همچنین پاسخگویی به درخواستهای حساس – مثل توصیههای پزشکی یا هر موردی که آسیب به شخص را در پی داشته باشد – (در چارچوب سیاستهای OpenAI) تا 29 درصد بیشتر شده است.

با توجه به سرمایهگذاری 10 میلیارد دلاری مایکروسافت در OpenAI، بدون شک شرکتی که بیش از همه از منافع GPT-4 سود میرد، مایکروسافت خواهد بود. همان طور که میدانید بسیاری از محصولات مایکروسافت در حال یکپارچه شدن با تکنولوژی جدید OpenAI هستند. اما در این میان یکپارچه شدن سرویس ابری مایکروسافت – موسوم به Azure – با این مدل هوش مصنوعی از اهمیت ویژهای برخوردار است. زیرا از این پس، هر زمان که یک شرکت اقدام به استفاده از تکنولوژی OpenAI کند، خواهناخواه این کار باید به واسطه Microsoft Azure صورت بگیرد.

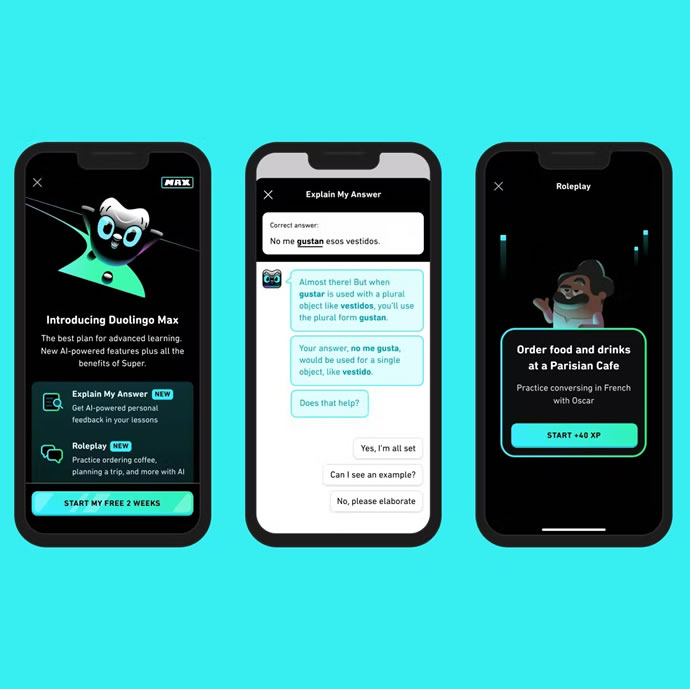

به غیر از مایکروسافت کمپانیهای دیگری نیز در حال به خدمت گرفتن GPT-4 هستند؛ کمپانی ایرلندی-آمریکایی Stripe با استفاده از GPT-4 اقدام به اسکن وبسایتهای کسبوکار کرده و خلاصه وضعیت آنها را در اختیار کارمندان بخش پشتیبانی قرار میدهد. Duolingo از این مدل هوش مصنوعی برای ایجاد یک ردیف اشتراکی جدید برای زبانآموزان استفاده میکند. کمپانی مالی Morgan Stanley در حال توسعه سیستمی مبتنی بر GPT-4 است که اطلاعات را از اسناد شرکت گرفته و در اختیار تحلیلگران مالی قرار دهد. حتی آکادمی خان نیز (Khan Academy) با استفاده از GPT-4 اقدام به توسعه آموزگارهای خودکار کرده است.

-

شیائومی Poco X7 Pro در نگاه رسانهها – نقاط ضعف و قوت از دید حرفهایها

شیائومی Poco X7 Pro در نگاه رسانهها – نقاط ضعف و قوت از دید حرفهایها

-

معرفی سامسونگ Galaxy M56 با ضخامت کمتر، پشت و روی شیشهای و عقبگرد در پردازنده و اسپیکر

معرفی سامسونگ Galaxy M56 با ضخامت کمتر، پشت و روی شیشهای و عقبگرد در پردازنده و اسپیکر

-

معرفی nubia RedMagic 10 Air گوشی مخصوص بازی نوبیا با باتری 6,000mAh و ضخامت 7.85 میلیمتری

معرفی nubia RedMagic 10 Air گوشی مخصوص بازی نوبیا با باتری 6,000mAh و ضخامت 7.85 میلیمتری

-

معرفی Honor Power میانرده آنر با Snapdragon 7 Gen 3 و باتری رکوردشکن 8,000 میلی آمپر ساعتی!

معرفی Honor Power میانرده آنر با Snapdragon 7 Gen 3 و باتری رکوردشکن 8,000 میلی آمپر ساعتی!

-

گزارش Counterpoint از بازار جهانی اسمارتفون در سهماهه نخست 2025 – صدرنشینی اپل به لطف آیفون 16e

گزارش Counterpoint از بازار جهانی اسمارتفون در سهماهه نخست 2025 – صدرنشینی اپل به لطف آیفون 16e

-

آشنایی با Galaxy Tab Active5 Pro – تبلت مقاوم سامسونگ با Snapdragon 7s Gen 3 و قلم S Pen

آشنایی با Galaxy Tab Active5 Pro – تبلت مقاوم سامسونگ با Snapdragon 7s Gen 3 و قلم S Pen

-

معرفی Galaxy XCover7 Pro با SD 7s Gen 3، باتری قابل تعویض حجیمتر و 7 سال آپدیت سیستمعامل

معرفی Galaxy XCover7 Pro با SD 7s Gen 3، باتری قابل تعویض حجیمتر و 7 سال آپدیت سیستمعامل